“社交偷懒”是一种现象,当团队成员因为知道其他人会替他们工作而开始减少努力时就会发生。科学家们调查这种情况是否发生在机器人和人类结合工作的团队中,发现执行质量保证任务的人类在被告知机器人已经检查过一件物品时发现的错误较少,这表明他们依赖机器人并且较少关注工作。

现在,技术的进步意味着一些机器人可以与人类一起工作,有证据表明,这些人类已经学会将它们视为队友,而团队合作可以对人们的表现产生消极和积极的影响。人们有时会放松,让同事做工作。这被称为“社交偷懒”,当人们知道自己的贡献不会被注意到或者他们已经适应了其他团队成员的高绩效时,这种现象很常见。柏林工业大学的科学家研究了人类在与机器人一起工作时是否存在社交懒惰现象。

“团队合作是喜忧参半”,该研究的第一作者 Dietlind Helene Cymek 说道。。“一起工作可以激励人们表现出色,但也可能导致人们失去动力,因为个人贡献不那么明显。我们感兴趣的是,当团队伙伴是机器人时,我们是否也能找到这种激励效应。”

伸出援助之手

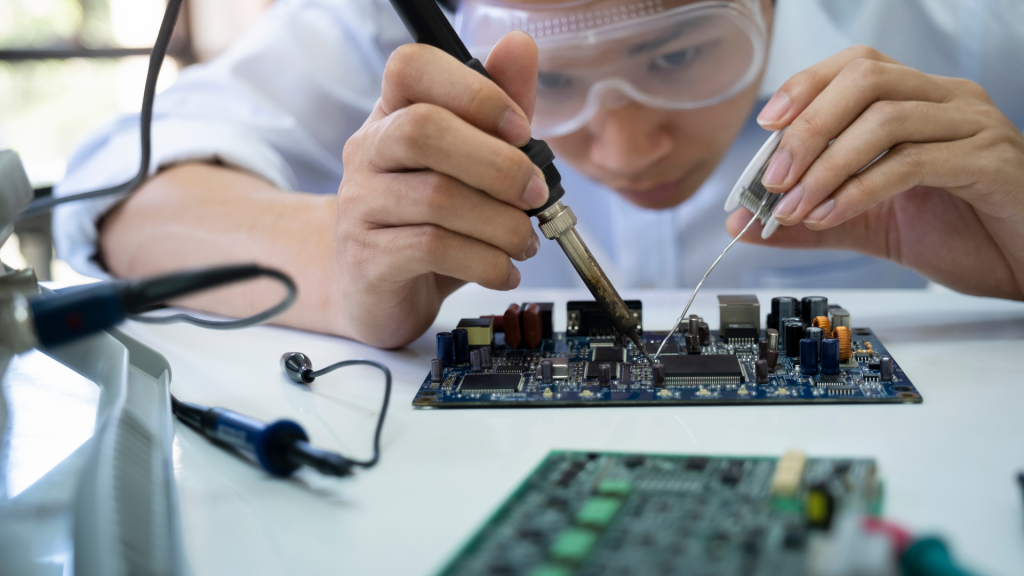

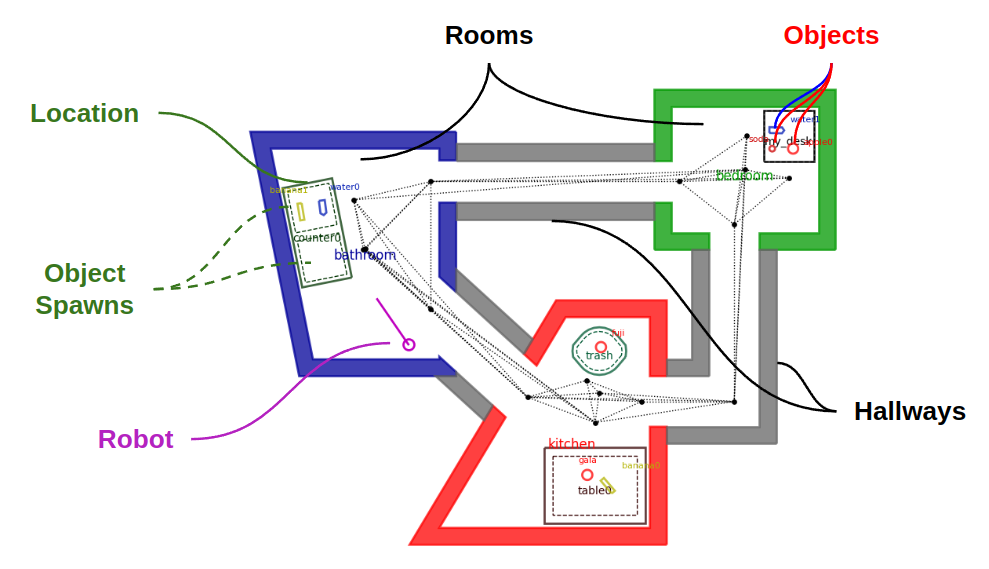

科学家们使用模拟工业缺陷检查任务测试了他们的假设:检查电路板是否有错误。科学家们向 42 名参与者提供了电路板的图像。电路板变得模糊,只有将鼠标工具放在上面才能查看锐化的图像。这使得科学家能够跟踪参与者对电路板的检查情况。

一半的参与者被告知,他们正在制作的电路板已被名为 Panda 的机器人检查过。尽管这些参与者没有直接与 Panda 一起工作,但他们在工作时见过并听到了机器人的声音。在检查了黑板并标记错误后,所有参与者都被要求对自己的努力进行评分,他们对任务的责任感以及他们的表现如何。

看却不见

乍一看,熊猫的存在似乎没有什么区别——在检查电路板的时间和搜索的区域方面,各组之间没有统计学上的显着差异。两组参与者对他们对任务的责任感、付出的努力和表现的评价相似。

但当科学家们更仔细地观察参与者的错误率时,他们意识到与 Panda 合作的参与者在任务后期发现的缺陷更少,而他们已经看到 Panda 成功标记了许多错误。这可能反映了一种“看而不见”的效应,即人们习惯于依赖某些东西,而较少在精神上参与它。尽管参与者认为他们给予了同等程度的关注,但他们下意识地认为 Panda 没有错过任何缺陷。

该研究的资深作者 Linda Onnasch 博士说:“追踪一个人正在看哪里很容易,但要判断视觉信息是否在心理层面得到充分处理就困难得多。”

安全有风险?

作者警告说,这可能会产生安全影响。“在我们的实验中,受试者完成这项任务的时间约为 90 分钟,我们已经发现,当他们在团队中工作时,发现的质量错误较少,”Onnasch 说。“在较长的轮班中,当任务是例行公事且工作环境几乎无法提供绩效监控和反馈时,动力的丧失往往会更大。在一般制造业中,尤其是在安全相关领域,双重检查很常见,这可能会对工作成果产生负面影响。”

科学家指出,他们的测试有一些局限性。虽然参与者被告知他们与机器人组成一个团队并展示了它的工作,但他们并没有直接与 Panda 一起工作。此外,社交偷懒很难在实验室中模拟,因为参与者知道他们正在被监视。

“主要的限制是实验室环境,”Cymek 解释道。“为了弄清楚人机交互中失去动力的问题有多大,我们需要深入实地,在真实的工作环境中测试我们的假设,让那些经常与机器人团队合作的熟练工人来测试我们的假设。”

版权声明

本文仅代表作者观点,不代表本网站立场。

本文系作者授权本网站发表,未经许可,不得转载。

发表评论